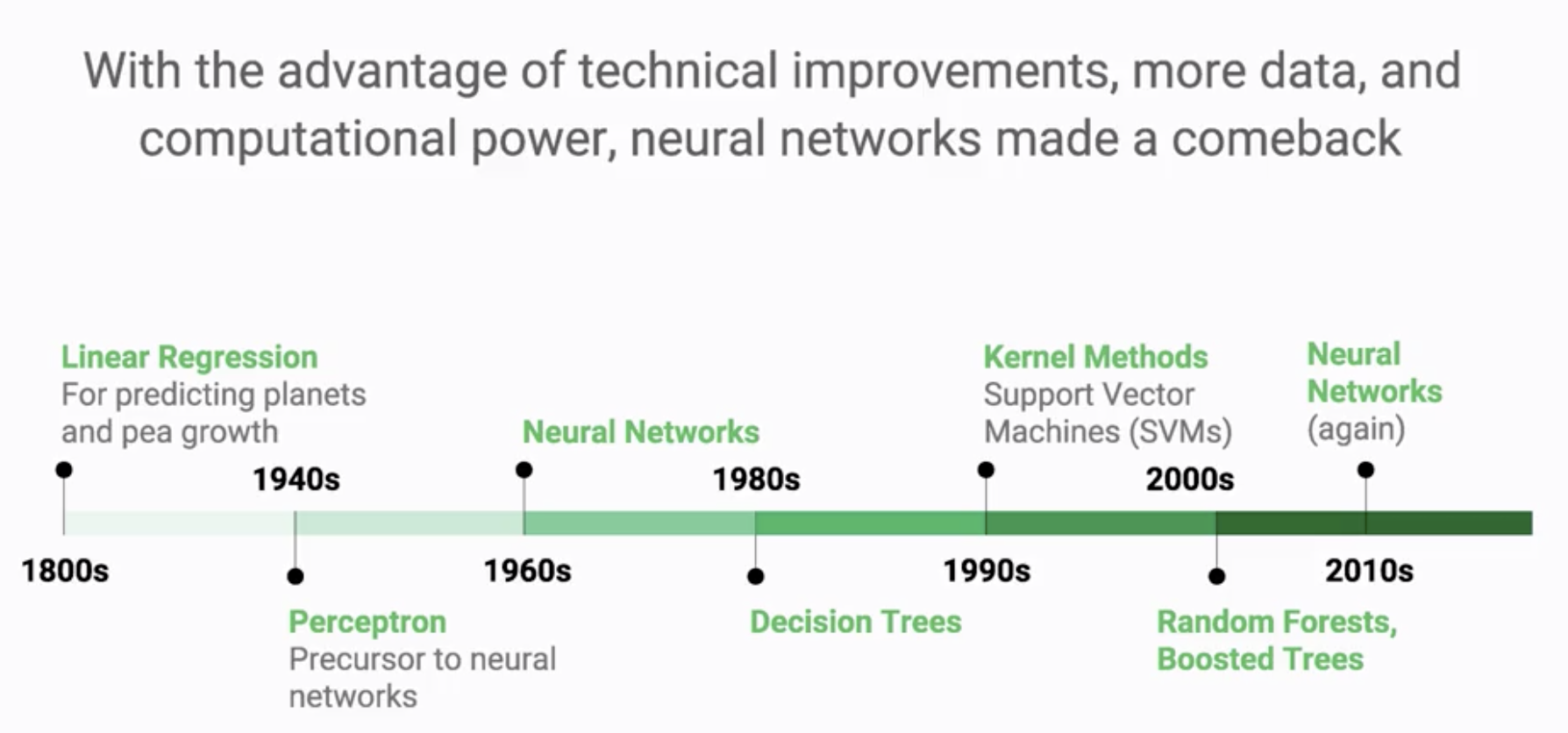

최근 들어서 다시 뉴럴네트워크의 시대가 되었음

CNN, RNN, GAN 과 같은 구조적인 부분의 기술 발전, 학습효율성을 늘려주는 ReLU 함수,

파라미터의 다양한 초기화 기법, 모델의 일반화를 위한 Dropout 기법 등이 등장하며 뉴럴넷이 더욱 발전함

그간, ML 모델에 등장한 여러 발전들이 신경망에서 다시 활용되었음,

머신러닝은 발전하며, 수백개의 층과 수백개의 파라미터로 이루어져있는 DNN으로 발전하였음.

위의 그림은 GoogLeNet (Inception)이라 불리는 이미지 분류모델을 도식화 한 것

2014년 이미지넷 대회에서 1,000개의 클래스를 가지는 120만개의 이미지를 학습함.

22개의 층(Pooling)을 포함하면 27개층의 뉴럴네트워크로 학습 파라미터의 개수는 1,100만였음.

(최근에는 훨씬 깊은 뉴럴네트워크도 많음)

노란 색 영역은 사람이 직접 손으로 분류했을 때의 에러율로 기계가 따라잡을 기준점

2014년까지는 사람에 못미쳤지만 2015년에 들어서서는 사람을 능가하는 성능을 기록함

딥러닝 모델이 발표되면 상세 스펙과 파라미터 등이 모두 공개되어

다양하게 실험하고 변형하다보니 성능이 빠르게 향상됨

'구글 머신러닝 스터디잼(중급) > Launching into Machine Learning' 카테고리의 다른 글

| Optimization 2 : Intro to Loss Function (0) | 2019.10.21 |

|---|---|

| Optimization 1 : Defining ML Models (0) | 2019.10.21 |

| ML History 6 : Random Forests (0) | 2019.10.21 |

| ML History 5 : Kernel Methods (0) | 2019.10.21 |

| ML History 4 : Decision Tree (0) | 2019.10.20 |